Det faglige nivået til vitenskapelige artikler, prosjekter og forskere vurderes i dag hovedsakelig ut fra den antatte kvaliteten på tidsskriftene der forskningen er publisert. Et mye brukt kvalitetsmål er tidsskriftets impaktfaktor, som angir gjennomsnittsverdien av hvor ofte artiklene i tidsskriftet er blitt sitert.

PER OTTAR SEGLEN, Professor emeritus, Universitetet i Oslo

Artiklenes siteringshyppighet er imidlertid ekstremt skjevfordelt, noe som innebærer at tildeling av samme poengsum (impaktfaktoren) til alle vil favorisere det store flertallet av lavt siterte artikler og forfattere på bekostning av det høyest siterte mindretallet.

Denne urettferdige og misvisende definisjonen på vitenskapelig kvalitet leder forskerne inn i et karrierejag der publisering i høyimpakt-tidsskrifter blir viktigere enn å utføre forskning av høy kvalitet. Her ligger kanskje en hovedårsak til at tidsskriftene jukser med sine impaktfaktorer, og til at forskerne manipulerer forskningsresultater i en slik grad at mesteparten av den publiserte forskningen ikke kan reproduseres.

Tidsskrift-impaktfaktoren

Eugene Garfield, grunnleggeren av siteringsdatabasen Science Citation Index, introduserte i 1972 tidsskrift-impaktfaktoren som et kvantitativt mål for tidsskriftkvalitet. Faktoren er i prinsippet et gjennomsnittstall for hvor ofte artiklene i et tidsskrift er sitert, det vil si referert til, i vitenskapelige publikasjoner i løpet av ett bestemt år.

I praksis er impaktfaktoren basert på en brøk der telleren angir antall siteringer gitt dette året til alle innlegg publisert i tidsskriftet de foregående to årene, mens nevneren bare inkluderer «substansielle artikler og over-siktsartikler» publisert i tidsskriftet de samme to årene.

Begrunnelsen for nevner-spesifikasjonen er at mange typer tidsskriftinnlegg regnes som «usiterbare», blant annet lederartikler, korrespondanse, kommentarer, perspektiver og nyheter (Garfield 2006), og derfor ikke blir tatt med i nevneren. Eventuelle siteringer til disse blir likevel inkludert i telleren! Denne innleggsklassifiseringen er ikke uten problemer, som vi skal se seinere.

Siteringer er ikke noe direkte mål på vitenskapelig kvalitet, men mer et uttrykk for nytteverdi innen forskning (Aksnes 2019). Tidsskriftrangeringer basert på impaktfaktorer korrelerer imidlertid godt med det allment aksepterte kvalitetshierarkiet for tidsskrifter, og faktoren ble derfor raskt godtatt som et tidsskriftkvalitetsmål. Ved en logisk feilslutning ble det antatt at impaktfaktoren da også måtte være et adekvat mål for kvaliteten på de enkelte artiklene i tidsskriftet og deres forfattere, fordi faktoren jo var definert som gjennomsnittet av artiklene!

Trass i sterke advarsler blant annet fra Garfield selv (2001) og andre (Seglen 1997) er denne idéen blitt entusiastisk omfavnet av forskningsledere og administratorer over hele verden, som en unik mulighet til å kvalitetsbedømme forskere og deres prosjekter på en rask og billig måte.

Hvor representativ er tidsskrift-impaktfaktoren?

Er tidsskrift-impaktfaktoren tilstrekkelig representativ for tidsskriftets individuelle artikler? I så fall måtte siteringshyppigheten til enkeltartiklene i et tidsskrift vært smalt normalfordelt rundt gjennomsnittet (impaktfaktoren).

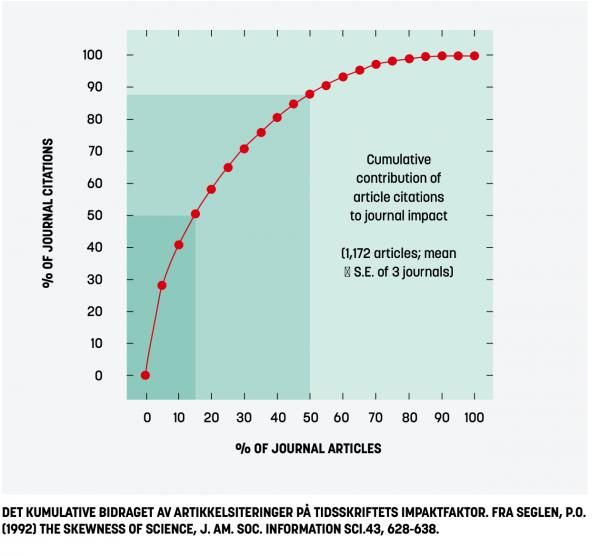

En manuell opptelling for 30 år siden viste imidlertid at fordelingen av siteringer tvert imot var ekstremt skjev (Seglen 1989), uansett hvilket tidsskrift og impaktnivå som ble undersøkt (Seglen 1992). En slik skjevfordeling ser ut til å være en universell lov, som er blitt reprodusert i mange påfølgende studier (Larivière 2016, Zhang 2017).

En liten andel av artiklene, omtrent femteparten, mottar halvparten av siteringene og er derfor bestemmende for hvor høy tidsskriftets impaktfaktor blir. De resterende fire femdelene er lavt sitert eller ikke sitert i det hele tatt (se figuren). Det er for øvrig ingen grunn til å tro at reell artikkelkvalitet er mindre skjevfordelt enn siteringshyppighet, siden ekstreme skjevfordelinger er karakteristiske for fenomener med et komplekst årsaksgrunnlag (West 1990, Seglen 1992).

En vurdering som tillegger alle artikler og artikkelforfattere i et tidsskrift samme kvalitet, vil være misvisende og urettferdig, fordi den belønner de dårligste på bekostning av de beste. Flertallet får en «gratistur» (Baum 2011) eller «pynter seg med lånte fjær», noe som er blitt antydet som en medvirkende årsak til impaktfaktorens store popularitet (Osterloh 2020).

Den internasjonale matematiker-unionen (IMU) har betegnet denne formen for evaluering som «et gjennomført misbruk av statistikk som alltid må bekjempes» (Adler 2008). EU-kommisjonen har karakterisert det de kaller «impaktfaktor-bedrageriet» som «meningsløst» (O’Carroll 2017).

DORA-erklæringen (San Francisco Declaration on Research Assessment, 2013), undertegnet av mer enn 16 000 institusjoner og enkeltforskere over hele verden, er krystallklar i sitt hovedbudskap: «Ikke bruk tidsskriftbaserte indikatorer, som tidsskrift-impaktfaktorer, som surrogatmål for kvaliteten på individuelle artikler til å bedømme en individuell forskers bidrag, eller ved ansettelser, forfremmelser eller beslutninger om prosjektstøtte.»

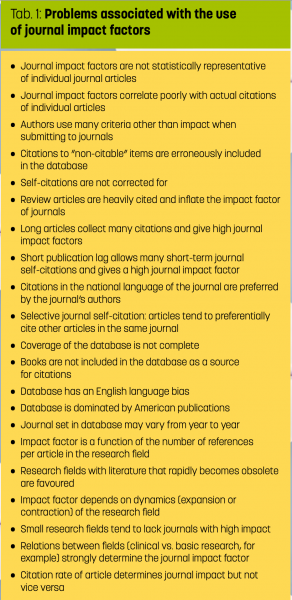

Foruten mangelen på representativitet, er tidsskrift-impaktfaktoren beheftet med en lang rekke tekniske og prinsipielle problemer (Tab. 1). Publikasjonen som denne problemlista er hentet fra, var for øvrig et av grunnlagsdokumentene for DORA-erklæringen.

Tidsskrift-impaktfaktorer kan inflateres gjennom manipulering og juks

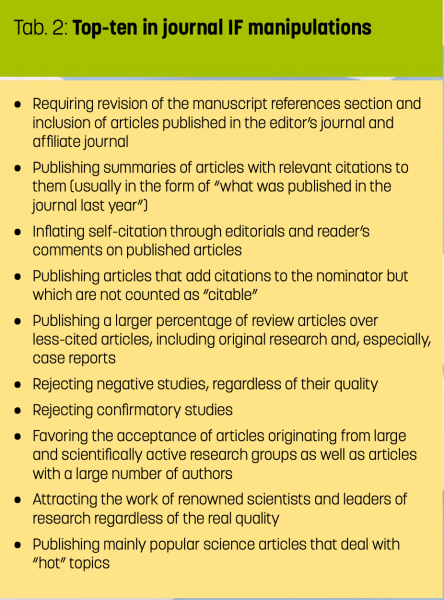

Redaktører er naturligvis interessert i å få sitt tidsskrifts impaktfaktor så høy som mulig, noe som kan gjøres på mange måter (Tab. 2). Én strategi er å tiltrekke seg artikler og forfattere som forventes å bli høyt sitert; en annen er å avvise innlegg med dårlig siteringspotensial. En tredje er å selvsitere eget tidsskrift gjennom ledere, sammendrag og kommentarer, eller – atskillig verre – å kreve tilleggsreferanser til eget tidsskrift ved revisjon av manuskripter (Larivière 2018).

Det aller verste, og mest effektive, er imidlertid å manipulere impaktfaktor-brøken ved å klassifisere høyst siterbare innlegg som «usiterbare», det vil si inkludere siteringer til disse i telleren uten å inkludere innleggene i nevneren. Generelle tidsskrifter med mange typer innlegg, som Nature og Science, har skaffet seg en høy impaktfaktor blant annet på denne måten (Larivière 2018).

Flere av verdens ledende medisinske tidsskrifter mangedoblet sine impaktfaktorer i løpet av 2000-tallet, parallelt med en påfallende reduksjon i antall artikler og en tilsvarende økning i «redaksjonelt materiale» (Davis 2016). FASEB J. høynet i 1989 sin impaktfaktor fra 0.2 til 18 ved å omklassifisere konferansesammendrag til «usiterbare» innlegg (Gowrishankar 1999). Curr. Biol.’s impakt-faktor steg fra 7.0 i 2002 til 11.9 i 2003, etter at nesten halvparten av artiklene fra 2001- årgangen (som inngikk i impaktfaktorberegningen både i 2002 og 2003) var blitt omklassifisert til «usiterbare» innlegg i 2003 (Brembs 2013). Dette er naturligvis ren svindel.

I 2006 avslørte PLoS Medicine at slikt impaktfaktor-juks åpenbart skjer ganske ofte, i samarbeid mellom tidsskriftene og det private firmaet som produserer faktorene. I forhandlinger med dette firmaet ble PLoS-redaktørene tilbudt en impaktfaktor mellom 2 og 11, som kunne konstrueres gjennom kreativ klassifisering av de forskjellige typene innlegg.

Redaktørene ble imidlertid så rystet at de valgte å avbryte forhandlingene og eksponerte isteden firmaets «uvitenskapelige, subjektive og hemmeligholdte» manipulering i en lederartikkel titulert «The Impact Factor Game: It is time to find a better way to assess the scientific literature». Det kan man vel trygt si seg enig i.

Tidsskriftbasert evaluering av individuelle forskere kan ha skadelige konsekvenser

De mange advarslene fra DORA og andre er gjenspeilet i premissene for den tidsskrift- baserte norske publiseringsindikatoren (NPI) som fastslår at denne «kan ikke brukes til å trekke konklusjoner om den enkelte publikasjon eller den enkelte forsker» (UHR 2004), for eksempel ved karriereoppfølging eller i ansettelsessammenhenger (NPI 2018). Ikke desto mindre blir både NPI og impakt- faktorer ofte benyttet til evaluering av indi- viduelle forskere ved våre akademiske insti- tutter (Aagaard 2014, Brekke 2019).

I en komitébedømmelse av søkere til en biomedisinsk stilling ved UiO tidligere i år ble «vitenskapelig kvalitet» utelukkende vurdert på grunnlag av tidsskrifter og im- paktfaktorer, uten noen henvisninger til innholdet i de innleverte artiklene. Alle de topp-prioriterte kandidatene hadde for øv- rig artikler i høyimpakt-tidsskrifter som Nature eller Cell.

Det er mye som kan tyde på at en vellyk- ket vitenskapelig karriere ikke lenger er mu- lig uten artikler i tidsskrifter med høyt im- pakt. Ledende forskere over hele verden har slått alarm fordi karrierehensyn presser unge forskere til å jage publisering i høyimpakt- tidsskrifter framfor å fokusere på forskning av høy kvalitet (Schekman 2013, Heckman 2018, Hendrix 2018). Dette diskuteres som en mulig årsak til den betydelige utbredel- sen av unøyaktig forskning og manipulerte resultater (Gerrits 2019, Goldacre 2019), godt dokumentert også i Norge (Hjellbrekke 2018, 2019).

Det er anslått at mesteparten av dagens publiserte forskningsresultater ikke kan re- produseres (Ioannidis 2005, 2014; Chalmers 2009). Dette har skapt spesielt store proble- mer for farmasøytisk industri, som i god tro har basert seg på manipulert og misvisende preklinisk forskning (Prinz 2011, Begley 2012, Coghlan 2017) og ditto kliniske ut- prøvninger (Chalmers 2009, Goldacre 2019). Industriens egne forskere har pekt på at nett- opp karrieredrevet press for å levere «per- fekte historier» til høyimpakttidsskrifter kan bidra til at så mye medisinsk forskning er feilslått (Begley 2012), noe som iallfall ikke kommer pasientene til gode.

Ved å tviholde på en kvalitetsindikator som ikke bare er villedende og urettferdig, men som også ser ut til å kunne ha destruk- tive følgevirkninger, risikerer vi at akade- misk forskning faktisk kan medvirke til en kunnskapskrise. Universiteter og institut- ter bør derfor snarest mulig kvitte seg med all tidsskriftbasert evaluering av individuel- le forskere og artikler, gjerne gjennom et eksplisitt reglementsfestet forbud. Det er ikke nok å underskrive DORA-erklæringen, den må også implementeres (O’Carroll 2017).

Referanser

Aagaard K, Bloch C & Schneider JW (2014) Evaluering af den norske publiceringsindikator. Aarhus Universitet, 109 pp.

Adler R, Ewing J & Taylor P (2008) Citation statistics: A report from the International Mathematical Union (IMU) in cooperation with the International Council of Industrial and Applied Mathematics (ICIAM) and the Institute of Mathematical Statistics (IMS). Joint Committee on Quantitative Assessment of Research, 26 pp.

Aksnes DW, Langfeldt L & Wouters P (2019) Citations, citation indicators, and research quality: An overview of basic concepts and theories. SAGE Open 9, 1-17.

Baum JAC (2011) Free-riding on power laws: questioning the validity of the impact factor as a measure of research quality in organization studies. Organization 18, 449-466.

Begley CG & Ellis LM (2012) Raise standards for preclinical cancer research. Nature 483, 531-533.

Brekke T, Netteland A & Sommerset Busengdal H (2019) Hvordan bør vi måle forskningskvalitet? Civita-notat 26, 6 pp.

Brembs B, Button K & Munafò M (2013) Deep impact: unintended consequences of journal rank. Front. Hum. Neurosci. 7: 291.

Chalmers I & Glasziou P (2009) Avoidable waste in the production and reporting of research evidence. The Lancet 374, 86-89.

Coghlan A (2017) Key Alzheimer’s drug shows ‘virtually no chance of working’. NewScientist, https://www.newscientist.com/article/2121497-key-alzheimers-drug-shows-virtually-no-chance-of-working/.

Davis P (2016) Citable items: The contested impact factor denominator. The Scholarly Kitchen,https://scholarlykitchen.sspnet.org/2016/02/10/citable-items-the-contested-impact-factor-denominator/, 4 pp.

Falagas ME & Alexiou VG (2008) The top-ten in journal impact factor manipulation. Arch. Immunol. Ther. Exp. 56, 223-226.

Garfield E (1972) Citation analysis as a tool in journal evaluation. Science 178, 471-479.

Garfield E (2001) Impact factors, and why they won’t go away. Nature 411, 522.

Garfield E (2006) The history and meaning of the journal impact factor. J. Am. Med. Assoc. 295, 90-93.

Gerrits RG, Jansen T, Mulyanto J, van den Berg MJ, Klazinga NS & Kringos DS (2019) Occurrence and nature of questionable research practices in the reporting of messages and conclusions in international scientific Health Services Research publications: a structured assessment of publications authored by researchers in the Netherlands. BMJ Open9: e027903.

Goldacre B, Drysdale H, Dale A, Milosevic I, Slade E, Hartley P, Marston C, Powell-Smith A, Heneghan C & Mahtani KR (2019) COMPare: a prospective cohort study correcting and monitoring 58 misreported trials in real time. Trials 20: 118.

Gowrishankar J & Divakar P (1999) Sprucing up one’s impact factor. Nature 401, 321-322.

Heckman J & Moktan S (2018) Publishing and promotion in economics: The tyranny of the Top Five. VOX CEPR Policy Portal, https://voxeu.org/article/publishing-and-promotion-economics-tyranny-top-five, 7 pp.

Hendrix S (2018) Do I need Nature or Science papers for a successful career in Science? https://smartsciencecareer.com/do-i-need-nature-papers/, 2 pp.

Hjellbrekke J, Drivdal L, Ingierd H, Rekdal OB, Skramstad H, Torp IS & Kaiser M (2018) Etikk og integritet i forskning: resultater fra en landsomfattende undersøkelse. Universitetet i Bergen, 28 pp.

Hjellbrekke J, Ingierd H & Kaiser M (2019) Diskutabel forskningspraksis: holdninger og handlinger. Universitetet i Bergen, 16 pp.

Ioannidis JPA (2005) Why most published research findings are false. PLoS Med. 2: e124.

Ioannidis JPA (2014) How to make more published research true. PLoS Med. 11: e1001747.

Larivière V, Kiermer V, MacCallum CJ, McNutt M, Patterson M, Pulverer B, Swaminathan S, Taylor S & Curry S (2016) bioRxiv 062109.

NPI (Norsk publiseringsindikator) (2019) https://npi.nsd.no/informasjon/, 9 pp.

O’Carroll C, Rentier R, Cabello Valdes C, Esposito F, Kaunismaa E, Maas K, Metcalfe J, McAllister D & Vandevelde K (2017) Evaluation of research careers fully acknowledging Open Science practices. European Comission, European Union, ISBN 978-92-79-70515-1, 29 pp.

Osterloh M & Frey BS (2020) How to avoid borrowed plumes in academia. Research Policy, in press.

Prinz F, Schlange T & Asadullah K (2011) Believe it or not: how much can we rely on published data on potential drug targets? Nature Rev. Drug Discov. 10, 328-329.

San Francisco Declaration on Research Assessment (2013). http://www.ascb.org/dora/, 10 pp.

Schekman R (2013) How journals like Nature, Cell and Science are damaging science. The Guardian, https://www.theguardian.com/commentisfree/2013/dec/09/how-journals-nature-science-cell-damage-science, 3 pp.

Seglen PO (1989) Kan siteringsanalyse og andre bibliometriske metoder brukes til evaluering av forskningskvalitet? NOP-Nytt (Helsingfors) 15, 2-20.

Seglen PO (1992) The skewness of science. J. Am. Soc. Information Sci. 43, 628-638.

Seglen PO (1997) Why the impact factor of journals should not be used for evaluating research. Br. Med. J. 314, 498-502.

The PLoS Medicine Editors (2006) The impact factor game. PLoS Med. 3: e291.

UHR (Universitets- og høgskolerådet) (2004) Vekt på forskning: Nytt system for dokumentasjon av vitenskapelig publisering. 83 pp.

West BJ & Shlesinger M (1990) The noise in natural phenomena. Am. Scientist 78, 40-45.

Zhang L, Rousseau R & Sivertsen G (2017) Science deserves to be judged by its contents, not by its wrapping: Revisiting Seglen’s work on journal impact and research evaluation. PLoS One 12, e0174205.

Illustrasjon: Lars Fiske